成果|張小志課題組及合作者提出一種多模态醫學影像融合新方案

近期,2003网站太阳集团電氣工程學院張小志課題組及合作者提出了一種聯合Swin Transformer和多尺度卷積神經網絡的無監督深度神經網絡,用于多模态醫學影像的融合。相關研究成果以“MRSCFusion: Joint Residual Swin Transformer and Multiscale CNN for Unsupervised Multimodal Medical Image Fusion”為題,在國際權威期刊《IEEE Transactions on Instrumentation and Measurement》上發表。

醫學影像是臨床診斷的重要手段,由于解剖結構影像和功能影像的成像原理不同,單模态醫學影像的信息存在着局限性。通過圖像融合技術将不同模态的醫學影像融合在一起,實現不同模态間互補信息和突顯優勢,增強影像信息量,有助于更準确診斷和有效治療。

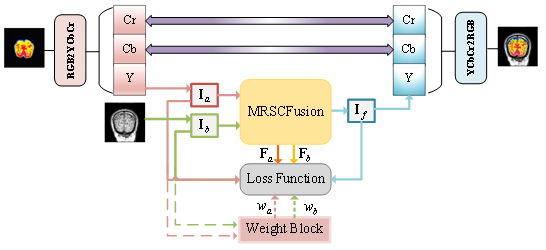

基于卷積神經網絡的深度學習方法因其強大的建模能力而被應用于圖像融合,但其感受野的局部性限制了融合性能的提升。為解決這個問題,張小志課題組提出一種全新的無監督多模态醫學影像融合框架,設計了一個聯合Swin Transformer和卷積神經網絡模塊對多尺度醫學影像特征進行融合,該模塊由一個用于捕獲全局上下文信息的殘差Swin Transformer分支和一個用于捕獲局部細粒度信息的卷積神經網絡分支組成。

此外,為進一步有效地保留醫學影像的紋理特征和強度信息,定義了包含内容損失和強度損失的聯合損失函數來約束融合模塊,并引入自适應權重來控制源圖像的信息保留程度。所提出的框架在CT-MRI、PET-MRI和SPECT-MRI等多個融合任務上進行實驗,通過定性和定量分析驗證了模型的優越性。

2003网站太阳集团電氣工程學院碩士生謝欣宇為第一作者,張小志副教授為通訊作者。其他合作者包括2003网站太阳集团、計算機學院和2003网站太阳集团附屬第一醫院的科研人員。上述研究工作得到國家自然科學基金面上項目(62071213,61871210)的資助。論文鍊接:https://ieeexplore.ieee.org/document/10256252